Jika Anda memiliki sebuah website, salah satu aspek teknis yang perlu Anda pahami adalah robots.txt. Meskipun terdengar teknis, robots.txt sebenarnya adalah file sederhana yang memiliki peran penting dalam SEO dan pengelolaan akses mesin pencari ke situs Anda.

Dalam artikel ini, kita akan membahas secara lengkap tentang apa itu robots.txt, fungsi dan pentingnya bagi SEO, cara kerjanya, serta langkah-langkah membuat dan mengeceknya.

Daftar Isi

Apa Itu Robots.txt?

Robots.txt adalah file teks sederhana yang digunakan untuk mengatur bagaimana bot mesin pencari (web crawlers) mengakses halaman di situs web Anda.

File ini ditempatkan di root direktori situs web dan berisi aturan yang menginstruksikan bot mengenai halaman mana yang boleh atau tidak boleh di-crawl.

Sebagai contoh, jika Anda tidak ingin halaman tertentu muncul di hasil pencarian Google, Anda bisa memblokirnya dari perayapan menggunakan robots.txt. Namun, perlu diingat bahwa robots.txt tidak sepenuhnya mencegah pengindeksan halaman.

Meskipun bot tidak merayapi halaman tersebut, halaman tetap bisa diindeks jika sudah memiliki tautan eksternal.

File robots.txt juga membantu mengoptimalkan penggunaan sumber daya bot, sehingga bot hanya merayapi halaman yang relevan dan menghindari halaman yang tidak perlu diindeks, seperti halaman admin atau halaman duplikat.

Fungsi Robots.txt

Dalam dunia digital yang semakin kompetitif, mengoptimalkan visibilitas website di mesin pencari menjadi prioritas bagi banyak pemilik situs. Salah satu elemen penting dalam pengelolaan akses mesin pencari adalah penggunaan robots.txt.

Robots.txt memiliki beberapa fungsi utama yang sangat penting bagi pemilik website, antara lain:

1. Mengontrol Akses Bot Mesin Pencari

Robots.txt memungkinkan Anda membatasi halaman tertentu agar tidak diakses oleh bot mesin pencari, sehingga hanya halaman penting yang dapat dirayapi.

2. Menghindari Perayapan Halaman Duplikat

Robots.txt dapat digunakan untuk mencegah bot merayapi halaman dengan konten duplikat, seperti versi cetak atau filter kategori dalam e-commerce.

Namun, untuk mengatasi duplikasi konten secara efektif, lebih disarankan menggunakan meta robots “noindex” atau canonical tag.

3. Menghemat Bandwidth Server

Mengarahkan bot hanya ke halaman yang diperlukan akan menghemat penggunaan bandwidth dan mempercepat waktu loading situs.

4. Mengelola Penggunaan Crawler Budget

Dengan membatasi akses ke halaman yang tidak perlu diindeks (seperti halaman admin atau hasil pencarian internal), robots.txt membantu mesin pencari lebih fokus merayapi halaman yang lebih penting untuk SEO, seperti halaman blog, produk dan kontak.

Pentingnya Robots.txt bagi SEO

Banyak orang bertanya, apakah robots.txt benar-benar diperlukan untuk SEO? Jawabannya, ya! Robots.txt sangat berperan dalam optimasi mesin pencari, karena:

- Memastikan halaman penting mendapatkan prioritas indeks.

- Menghindari perayapan halaman yang tidak diinginkan seperti halaman admin atau halaman berisi informasi sensitif.

- Membantu bot mesin pencari lebih efisien dalam meng-crawl situs web Anda.

Tanpa robots.txt yang dikonfigurasi dengan baik, bot bisa menghabiskan waktu merayapi halaman yang tidak relevan, yang pada akhirnya dapat menghambat performa SEO situs Anda.

Cara Kerja Robots.txt

Ketika bot mesin pencari mengunjungi sebuah website, mereka pertama kali mencari file robots.txt di root directory situs tersebut.

Jika file tersebut ada, bot akan membaca aturan yang tercantum di dalamnya dan menyesuaikan proses crawling mereka sesuai dengan instruksi yang diberikan.

Sebagai contoh, berikut adalah struktur dasar robots.txt:

User-agent: *

Disallow: /admin/

Disallow: /private/

Allow: /public/

Penjelasan:

- User-agent: * – Berlaku untuk semua bot mesin pencari.

- Disallow: /admin/ – Melarang bot untuk mengakses folder /admin/.

- Disallow: /private/ – Melarang bot untuk mengakses folder /private/.

- Allow: /public/ – Memungkinkan bot untuk mengakses folder /public/.

Cara Membuat Robots.txt

Setelah memahami fungsi robots.txt dalam mengatur akses web crawlers, langkah selanjutnya adalah menerapkannya dengan benar di website Anda.

Pembuatan robots.txt yang tepat dapat membantu memastikan bahwa mesin pencari hanya mengindeks halaman yang relevan, menghindari duplikasi konten, serta menjaga keamanan data sensitif. Membuat robots.txt sangat mudah. Ikuti langkah-langkah berikut:

1. Buat File Robots.txt

Gunakan text editor seperti Notepad atau Visual Studio Code, lalu simpan file dengan nama robots.txt.

2. Tentukan Aturan untuk Bot

Tulis aturan sesuai kebutuhan Anda. Misalnya, untuk melarang semua bot mengakses folder /images/:

User-agent: *

Disallow: /images/

Jika ingin mengizinkan Googlebot mengakses semua halaman kecuali folder /private/, gunakan:

User-agent: Googlebot

Disallow: /private/

3. Simpan dan Upload ke Server

Setelah selesai, unggah file robots.txt ke direktori root website Anda menggunakan FTP atau file manager di cPanel.

Cara Cek Robots.txt pada Website

Setelah membuat robots.txt, penting untuk mengecek apakah file tersebut bekerja dengan benar. Kesalahan dalam konfigurasi robots.txt dapat menyebabkan halaman penting tidak terindeks atau justru membiarkan halaman sensitif diakses oleh mesin pencari.

Oleh karena itu, pengecekan secara berkala sangat disarankan agar website tetap optimal dalam performa SEO dan keamanan.

Berikut beberapa cara untuk mengeceknya:

Cek Melalui Browser

Buka browser dan masukkan URL berikut:

https://www.namadomain.com/robots.txt

Jika file muncul dan isinya sesuai dengan yang Anda buat, berarti sudah terpasang dengan benar.

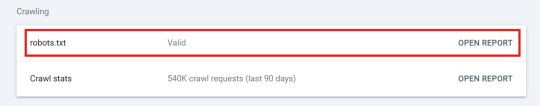

Gunakan Google Search Console

Google Search Console memungkinkan Anda untuk mengecek status robots.txt langsung melalui menu “Settings”.

- Masuk ke akun Google Search Console Anda.

- Di menu sebelah kiri, klik “Settings”, lalu pada bagian “Crawl”, klik “robots.txt”.

- Di sini, Anda bisa melihat apakah robots.txt valid atau ada error dalam konfigurasi

Cek dengan Alat Online

Beberapa alat online dapat membantu Anda memeriksa robots.txt, seperti:

- SEO Site Checkup Robots.txt Test

- SE Ranking Robots.txt Tester

- TechnicalSEO Robots.txt Validator and Testing Tool

Dengan menggunakan cara-cara di atas, Anda bisa memastikan bahwa robots.txt berfungsi dengan baik dan tidak menghalangi halaman penting untuk di-crawl.

Kesimpulan

Robots.txt adalah file sederhana tetapi sangat penting dalam manajemen akses mesin pencari ke situs web Anda. Dengan memahami cara kerja dan fungsi robots.txt, Anda bisa mengoptimalkan SEO, menghindari duplikasi konten, dan memastikan hanya halaman yang relevan yang diindeks oleh mesin pencari.

Pemilihan domain dan hosting yang tepat adalah langkah pertama untuk memastikan situs Anda berjalan dengan cepat dan stabil. Dengan hosting yang handal, Anda dapat meningkatkan performa dan kecepatan akses situs, yang sangat penting untuk SEO dan pengalaman pengguna.

Di Exabytes, kami menyediakan domain murah dan berbagai pilihan hosting berkualitas yang dapat disesuaikan dengan kebutuhan website Anda, baik untuk blog pribadi, toko online, atau website perusahaan.

Tidak hanya itu, dengan layanan hosting cepat dan dukungan pelanggan 24/7, Anda bisa fokus mengembangkan konten dan strategi marketing tanpa khawatir tentang downtime atau masalah teknis. Jangan biarkan masalah teknis menghambat kesuksesan situs Anda. Segera pilih domain dan hosting terbaik di Exabytes dan optimalkan website Anda untuk masa depan digital yang lebih cerah!

Pastikan juga Anda telah membuat dan mengatur robots.txt dengan benar sesuai kebutuhan website Anda. Jangan lupa untuk mengecek apakah konfigurasi yang Anda buat bekerja dengan baik agar tidak menghambat kinerja SEO situs Anda. Semoga artikel ini membantu Anda memahami robots.txt lebih dalam!